Introducción a la Inteligencia Artificial en la Educación

La inteligencia artificial (IA) se ha convertido en un componente esencial en el ámbito educativo, transformando la manera en que se enseña y se aprende. En este contexto, es fundamental entender cómo se puede integrar la IA en los procesos educativos de manera efectiva y responsable.

Uno de los aspectos más críticos en la implementación de la IA en la educación es la privacidad de los datos. Regularmente, cuando he tenido de hacer clases de inteligencia artificial integrada a los procesos educativos, hay una pregunta recurrente, y esta es cuando nosotros podemos proteger los datos y mantenerlos en privacidad.

El objetivo de este artículo es guiar a los educadores y a los interesados sobre la instalación de modelos de lenguaje locales, asegurando que se mantenga la privacidad y la seguridad de los datos en el proceso educativo.

Instalación de Modelos de Lenguaje Locales

En esta entrada vamos a tratar específicamente cómo instalar un modelo de lenguaje en nuestro computador y vamos a ir paso a paso.

Requisitos del sistema para la instalación

- Asegúrate de que tu computador tenga al menos 4 GB de RAM. Esto es importante ya que el rendimiento del modelo de lenguaje puede verse afectado por las características técnicas de tu equipo.

Pasos para descargar el modelo OLLAMA 3.2

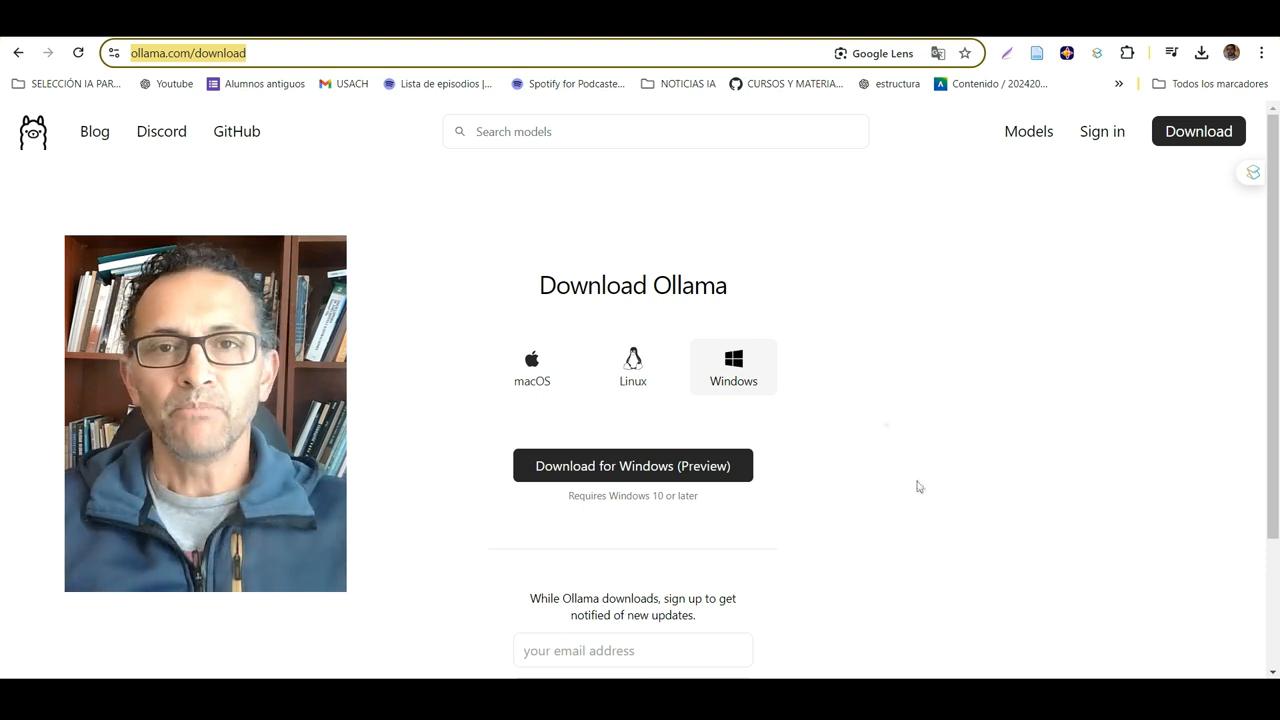

- Visita la página oficial de descarga de Ollama en ollama.com/download.

- Selecciona el sistema operativo correspondiente (macOS, Linux o Windows).

- Haz clic en el botón de descarga para Windows (Preview) si estás utilizando Windows 10 o posterior.

Ejecución del instalador y solución de problemas comunes

- Una vez descargado el instalador, ejecútalo y sigue las instrucciones en pantalla.

- Si experimentas lentitud, verifica las especificaciones de tu procesador y la cantidad de RAM disponible, ya que esto puede influir en el rendimiento del modelo.

Configuración y Uso del Modelo

Para comenzar a utilizar el modelo, lo primero que debemos hacer es ingresar a la página de descarga. En este caso, se recomienda descargar el modelo LLAMA 3.2, que es la versión más reciente. Es importante mencionar que este modelo puede ser un poco más limitado en comparación con otros modelos como los de OpenAI, pero es bastante eficiente para su uso local en computadoras con especificaciones moderadas.

Interfaz del modelo y características principales

Una vez descargado, al ejecutar el instalador, es posible que aparezca un mensaje de error. Si esto sucede, se sugiere ejecutar el instalador como administrador. Después de la instalación, se abrirá la interfaz del modelo, donde podremos interactuar con él. Sin embargo, para una experiencia más intuitiva, se recomienda descargar una aplicación adicional que facilite la conversación con el modelo.

Cómo interactuar con el modelo

Para interactuar con el modelo, podemos utilizar comandos simples. Por ejemplo, al escribir «hola», el modelo responderá rápidamente, mostrando su capacidad de respuesta local. También se puede preguntar sobre su identidad, y el modelo proporcionará información sobre su función y capacidades. Esto demuestra que, incluso en computadoras con recursos limitados, el modelo puede funcionar de manera efectiva.

Configuración de parámetros y optimización del rendimiento

Para optimizar el rendimiento, es recomendable ajustar ciertos parámetros. Por ejemplo, al interactuar con documentos extensos como PDFs, se sugiere establecer el número de tokens en un valor adecuado, como 9000, para evitar ralentizar el sistema. Además, se puede configurar el modelo para que se desactive automáticamente después de un período de inactividad, lo que ayuda a conservar recursos.

Con estos pasos, ya tendrás configurado y listo para usar el modelo JAMA 3.2 en tu computadora.

Ventajas de Usar Modelos Locales

- Privacidad de Datos: Los modelos locales permiten mantener los datos en privado, funcionando de manera local y conectándose a Internet sin comprometer la seguridad de la información.

- Ahorro Económico: Utilizar modelos locales puede resultar en un ahorro significativo de costos en comparación con modelos de lenguaje en la nube, como los de OpenAI y Anthropic, que tienen limitaciones de uso y costos asociados.

- Capacidad de Personalización: Aunque los modelos locales pueden no ser tan potentes como los de OpenAI, se pueden instalar modelos con miles de millones de parámetros, como el modelo de 3.2 de Yama de Meta, que funcionan adecuadamente para diversas aplicaciones.

- Flexibilidad en el Uso: Los modelos locales permiten realizar múltiples procesos y generar respuestas sin las restricciones de los modelos en la nube, lo que facilita la interacción y el uso de archivos, como PDFs y videos de YouTube.

- Accesibilidad: La funcionalidad de escuchar las respuestas puede ser útil para personas con discapacidades visuales, mejorando la accesibilidad de la tecnología.

- Interacción con Archivos: Se pueden cargar y procesar archivos directamente, permitiendo chatear con documentos y extraer información de páginas web, lo que amplía las posibilidades de uso del modelo.

This page was generated using videotopage.com